I matematici a lungo si sono chiesti se fosse possibile esprimere il numero

33 e 42 come somma di 3 cubi, cioe’ se l’equazione 33=x3+y3+x3

e 42=x3+y3+z3 avesse

una soluzione. Si sa che 29 puo’ essere

scritto come 33+13+13, per esempio, mentre 32

non e’ esprimibile come somma di 3 interi ognuno elevato alla terza potenza; ma

dopo circa 60 anni nulla si sa per il 33 e 42.

Negli ultimi mesi, Andrew

Booker un matematico dell’Universita’ di Bristol

ha finalmente risolto l’enigma grazie all’utilizzo di potenti supercomputer. Ha

scoperto che:

1.

33=(8,866,128,975,287,528)³ +

(–8,778,405,442,862,239)³ + (–2,736,111,468,807,040)³

2.

42=(-80,538,738,812,075,974)3

+ (80,435,758,145,817,515)3 + (12,602,123,297,335,631)3

Si tratta di interi con un elevato numero di cifre (16 e 17). Pensate che

questi numeri hanno un ordine di grandezza 7/8 volte maggiore della distanza

Terra-Sole espressa in Km. Da qui si evince la necessita’ dell’impiego di

supercomputer per portare a termine la ricerca di tali mostri numerici. Questa

notizia si e’ subito diffusa sulla rete e c’e’ stata una grande euforia da

parte degli ambienti di Teoria dei numeri. Ma perche’? Di sicuro una parte e’ giustificata dalla

difficolta’ nel trovare la soluzione di queste equazioni. E’ dal 1955 che i

matematici hanno provato a trovare le soluzioni intere che soddisfano

l’equazione:

k = x³ + y³

+ z³

con k, x, y e z numeri interi.

In alcuni casi le soluzioni sono facili, come per k=29; altre volte si sa

che la soluzione non esiste, come per tutti i numeri k che lasciano un resto di

4 o 5 quando divisi per 9, come per il numero 32. In genere pero’ le soluzioni

non sono cosi triviali, come per il caso di 33 e 42 dove i 3 interi sembrano

quelli di un biglietto della lotteria senza alcuna struttura prevedibile.

Al momento, per i matematici il solo modo per scoprire queste soluzioni e’

l’utilizzo della forza bruta dei computer per provare le differenti

combinazioni di cubi di interi e sperare nella vittoria. Con la soluzione trovata da Booker non ci sono

altri interi k al di sotto di 100 per cui non si conosce la soluzione

dell’equazione cubica. Questo risultato e’ arrivato non solo grazie

all’utilizzo di un supercomputer molto veloce ma anche grazie ad un nuovo modo

di effettuare la ricerca delle soluzioni (nuovo algoritmo).

E per k maggiore di 100 cosa succede? Ci sono al momento 11 interi che

ancora resistono tra 100 e 1000 e una infinita’ di essi oltre 1000. Purtroppo non c’e’ alcuna indicazione

teorica, nessun pattern che possa permettere ai matematici di avere un’idea di

dove cercare. Il classico ago in un pagliaio.

Ma allora, perche’ impegnare del tempo nella ricerca di questi numeri?

Quello che e’ interessante, secondo Booker, e’ che ogni nuova soluzione

puo’ aiutare a decidere cosa e’ vero circa il problema della somma dei 3 cubi. L’equazione di

questo problema

k = x³ + y³

+ z³

e’ quella che I teorici chiamano un’equazione

Diofantea, una specie di struttura algebrica, le cui

proprieta’ hanno affascinato i matematici per millenni. Queste equazioni sono

delle equazioni polinomiali le cui variabili sconosciute hanno dei valori

interi. Esse compaiono in diversi problemi, anche piuttosto semplici della vita

quotidiana. Esistono anche i sistemi di equazioni diofantee che rappresentano

una naturale estensione delle equazioni. Ad esempio, si immagini che un negoziante debba acquistare

un certo numero di maglioni a collo basso da 40 € ed un certo numero di

maglioni a collo alto da 60 €, avendo a disposizione 560 €. Si desidera sapere

quanti maglioni di un tipo e quanti dell’altro riesce ad acquistare,

nell’ipotesi di voler spendere l’intera cifra a disposizione. Indicando con y

il numero di maglioni a collo basso acquistati, ovviamente intero, essendo

improbabile che il negoziante voglia acquistare mezzo maglione, e con x quello

dei maglioni a collo alto, deve essere

40y + 60x = 560

→ 2y + 3x = 28 .

Si tratta di un’equazione in due incognite con coefficienti interi di cui

si ricercano le soluzioni intere.

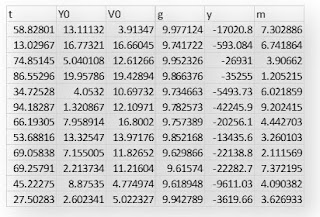

Qualche elementare considerazione numerica fornisce i risultati presentati

nella tabella precedente. Dunque, il negoziante ha alcune possibilità,

rappresentate dai quattro punti evidenziati in figura, e deciderà di approvvigionarsi

di un tipo oppure dell’altro tipo di maglione, a seconda delle scorte di

magazzino che possiede. È opportuno sottolineare che, se non vi fosse stato il

vincolo delle soluzioni intere, il problema avrebbe ammesso infinite soluzioni,

rappresentate da tutti i punti che si trovano sulla retta di seguito disegnata.

Se il negoziante dell’esempio appena sviluppato avesse avuto a disposizione

solamente di 550 €, decidendo sempre di spendere l’intera somma a disposizione,

come sarebbe cambiata la soluzione? Ebbene, sembra incredibile, ma non esiste

alcuna combinazioni di numeri interi che soddisfa l’equazione

40𝑥 + 60𝑦 = 550 → 4𝑥 + 6𝑦 = 55.

È facile convincersi di quanto affermato, osservando che il primo membro è

sempre un numero pari, mentre il secondo è dispari.

Le proprieta’ fondamentali delle equazioni Diofantee, ancora impegnano i

matematici di tutto il mondo. Per esempio, non esiste nessun metodo affidabile

che ci possa dire se una equazione Diofantea abbia o no una soluzione. Secondo

Booker, il problema della somma dei 3 cubi e’ una tra le piu’ semplici delle

equazioni Diofantee. E’ esattamente alla frontiera di cosa puo’ ancora essere

maneggiato anche se con difficolta’. Per questa ragione, gli esperti di Teoria dei

Numeri sono desiderosi di capire tutto quello che c’e’ da capire sulla somma

dei 3 cubi.

Un risultato sicuramente piu’ eclatante, sarebbe quello di provare la

congettura che

k = x³ + y³ + z³

ha un’infinita’ di soluzioni per ogni numero intero k, ad eccezione di

quelli che hanno come resto 4 o 5 quando divisi per 9. Gli strumenti concepiti

per tale dimostrazione potrebbero aiutare a forzare la logica del problema o

essere applicati ad altre equazioni Diofantee. I risultati di Booker, offrono

un supporto per questa congettura, dando ai matematici una maggiore confidenza

sulla ricerca della dimostrazione. In realta’, ogni qualvolta i matematici

hanno fatto una ricerca estendendo l’intervallo numerico, hanno trovato nuove

soluzioni rimuovendo cosi possibili controesempi alla congettura.

Ma chi era Diofanto? Vissuto nel III secolo dopo Cristo, è considerato l’iniziatore del

calcolo algebrico. Scrisse un trattato sui numeri

poligonali e sulle frazioni, ma la sua opera

principale sono gli Arithmetica, un trattato in tredici volumi dei quali

soltanto sei sono giunti fino a noi. La sua fama è principalmente legata a due

argomenti: le equazioni indeterminate ed il simbolismo matematico. Ben poco si

sa della sua vita e quel poco è stato trasmesso da Herbert Westren Turnbull (31

agosto 1885 – 4 maggio 1961), un storico inglese della Matematica che ha

rinvenuto e tradotto l’epigramma greco, noto come Epitaffio di Diofanto. Si tratta

di un problema aritmetico proposto sotto forma di epigramma e fa parte di una

raccolta di quarantasei indovinelli, che il grammatico latino Metrodoro, durante il VI secolo dopo Cristo, incluse nell’Antologia Greca. Tutti i

quesiti corrispondono ad equazioni di primo grado ad un’incognita. Ecco il

testo dell’indovinello. Questa tomba rinchiude Diofanto e, con grande

meraviglia, dice matematicamente quanto ha vissuto. La sua giovinezza durò un

sesto della sua vita; poi la sua barba iniziò a crescere dopo un dodicesimo; si

sposò dopo un settimo e gli nacque un figlio dopo cinque anni. Il figlio visse

la metà degli anni del padre e il padre morì quattro anni dopo il figlio.

Quanti anni visse Diofanto?

Detta 𝑥 l’età di

Diofanto, il problema si traduce nell’equazione

1 6 𝑥 + 1 12 𝑥 + 1 7 𝑥 + 5 + 1 2 𝑥 + 4 = 𝑥 → 𝑥 = 84 .

Se l’epitaffio corrisponde a verità, Diofanto morì all’età di

ottantaquattro anni.

Un altro indovinello di tipo diofanteo è stato proposto, qualche anno fa,

quale test di ingresso agli studi universitari tecnico-scientifici. Ecco il

testo. Fra tre anni Matteo avrà il doppio dell’età che Sara aveva tre anni fa,

mentre ora il quadruplo degli anni di lui è pari al quintuplo degli anni di

lei. Se è possibile determinarlo, qual è l’età di Matteo e di Sara? Si indichi

con 𝑥 l’età di Matteo

e con 𝑦 quella di Sara.

Per determinare queste due incognite intere, è sufficiente impostare un sistema

lineare di equazioni, utilizzando le due condizioni imposte dal testo

dell’indovinello. Precisamente, l’affermazione contenuta nel testo fra tre anni

Matteo avrà il doppio dell’età che Sara aveva tre anni fa, in termini

analitici, si trasforma nell’equazione 𝑥 + 3 = 2(𝑦 − 3) → 𝑥 − 2𝑦 = −9. Similmente, l’affermazione ora il quadruplo degli anni di lui è pari

al quintuplo degli anni di lei, diventa 4𝑥 − 5𝑦 = 0. Mettendole

insieme, risulta il sistema di due equazioni lineari [𝑥 − 2𝑦 = −9 , 4𝑥 − 5𝑦 = 0] , la cui soluzione costituisce

l’obiettivo dell’esempio. Prima però di risolverlo, è opportuno verificare che

esso ammetta un’unica soluzione, per cui è necessario verificare che il determinante | 1 −2 4 −5| = 3 ≠ 0 sia diverso da zero. Si ottiene allora che

𝑥 = 15, 𝑦 = 12,

cioè Matteo ha quindici anni e Sara ne ha dodici. La figura che segue

illustra in maniera grafica l’intersezione tra le due rette 𝑦 =( 𝑥 + 9)/2 (blu), 𝑦 = 4/5𝑥 (rossa), cioè la soluzione grafica

dell’indovinello: l’asse delle ascisse rappresenta l’età di Matteo, quello

delle ordinate indica invece l’età di Sara, e il punto 𝑃 è la soluzione del problema.