E’ possibile che la panna acida possa avere un impatto sulle cadute da motocicletta? O che il numero di persone morte per caduta dalla propria sedia a rotelle sia legato al costo delle patatine? O anche che il numero di film interpretati da

Cages sia proporzionale al numero di persone morte per annegamento in piscina? E mai possibile credere alla cosiddetta maledizione di Ramsey, che stabilisce che ogni volta che il centrocampista gallese dell’Arsenal,

Aaron Ramsey segna un gol, qualcuno di famoso nel mondo muore?

Ovviamente no anche se sembra essere cosi: grafici divertenti rivelano come la statistica possa creare delle false relazioni (date un occhiata

qui). Gli scienziati quotidianamente sono impegnati a cercare possibili correlazioni all’interno di grandi moli di dati per verificare ed eventualmente dimostrare certe teorie. Ma se due insieme di dati sono correlati tra loro da un punto di vista statistico non significa necessariamente che essi realmente siano strettamenti legati tra loro. Trovare una correlazione tra due insiemi non sempre significa causazione.

Questi grafici sono degli esempi di correlazioni spurie. Queste correlazioni in genere vengono trovate dai computer. Date due qualsiasi variabili essi calcolano velocemente grazie ai loro algoritmi interni un coefficiente statistico chiamato “

erre quadro R2” la cui vicinanza ad uno indica la bonta’ della correlazione. Ma la correlazione statistica in se non dice quasi nulla. C’e’ bisogno della conferma da parte dell’analista. Quello che esso deve fare e’ semplice: guardare i grafici che hanno una buona correlazione statistica, formulare un’ipotesi ed eventualmente rigettarla in base alla sua esperienza personale e background culturale. In genere se X e Y mostrano una correlazione quello che si fa e’ far variare la X e vedere cosa succede alla Y anche se cio’ non e’ sempre possibile. In un mondo sempre piu’ dominato dal

machine learning e dalla

scienza dei dati questo diventa il vero problema: l’incapacita’ di stabilire se una correlazione e’ casuale o causale. Questo non lo puo’ fare un computer ma solo un umano. Tutti gli scienziati del mondo stanno lavorando a questo problema e al momento non esiste alcuna soluzione. Trovare i meccanismi causali e’ il principale scopo di molte ricerche scientifiche in quanto ogni volta che troviamo un meccanismo causale riusciamo a fare un passo avanti nella conoscenza del mondo che ci circonda. A volte capita di vedere delle correlazioni che non riusciamo a spiegare e questo determina uno stimolo per gli scienziati a cercare una potenziale causa. Un buon esempio di correlazione che porta a delle conclusioni importanti e’ quello della connessione tra il tumore ai polmoni e il fumo. Agli inizi del 1990 si osservo’ un aumento di casi di tumore ai polmoni e nessuno sapeva il perche’. Nel 1929 il fisico

Fritz Lickint pubblico’ un articolo in cui mostrava che i pazienti con cancro ai polmoni per lo piu’ erano stati dei fumatori. Questo articolo diede inizio a tutta una ricerca grazie alla quale gli scienziati riconobbero la pericolosita’ del fumo. Senza il grafico di correlazione tutto questo non sarebbe potuto accadere. Le correlazioni tra due variabili possono essere delle mere coincidenze, o il risultato di una connessione causale sottostante. Ogni volta che vediamo una correlazione abbiamo l’opportunita’ di capire di cosa si tratti.

A volte le correlazioni tra due enti possono apparire spurie a causa delle cosiddette variabili omesse o

lurking variables. Sono proprio le variabili omesse a confondere le acque in quanto si muovono con le due variabili considerate ma non vengono osservate. Per esempio se guardiamo alla correlazione tra anni di istruzione e salario futuro si rischia di sopravvalutare l’effetto causale dell’istruzione sul salario se non si tiene conto per esempio della variabile abilita’. La ragione e’ che l’istruzione assorbe l’effetto dell’abilita’. Individui piu’ abili studiano per piu’ anni e guadagnano di piu’. Questo fa si ch uno pensa che il guadagno sia tutto dovuto all’istruzione senza pensare pero ‘ all’abilita’ della persona.

In generale, quindi un grafico da solo non serve a nulla. Da un punto di vista statistico le variabili omesse sono I serial killer di chi vuole dimostrare qualche cosa con un grafico. Altro esempio famoso di lurking variables e’ quello delle cicogne del paese austriaco di

Oldenburg. Riportando sulle ascisse di un grafico XY il numero di nidi di cicogne e in ordinate la popolazione del paese si osserva una correlazione positiva tra queste due variabili, correlazione ovviamente inaspettata. E’ possibile ipotizzare quindi che ci sia in giro qualche variabile omessa come il numero di cacciatori nelle campagne, il numero di comignoli delle nuove case, un migliore habitat nelle zone di riproduzione delle cicogne o chissa’ cos’altro.

Passiamo a un tema connesso che va sotto il nome di

paradosso di Simpson, cioe’ l’apparire di contraddizioni tra l’analisi di dati aggregati e dati disaggregati. Vediamo un esempio. Nel 1973

l’universita’ di Berkeley fu uno dei primi atenei ad essere denunciato per discriminazione di genere. Per l'ammissione al semestre autunnale di quell'anno furono esaminate 12.763 domande di iscrizione (8442 di ragazzi e 4321 di ragazze) e le ammissioni, suddivise per genere, furono quelle riportate nella tabella seguente.

Per l'università fu naturale disaggregare i dati per capire quali dipartimenti avevano contribuito a questa discrepanza. Quelli che seguono sono i dati dei sei principali dipartimenti.

Qui la differenza di genere è ancora più marcata: risultano ammessi circa il 45% dei maschi e il 30% delle femmine. Eppure in 4 dipartimenti la percentuale di ragazze ammesse è maggiore, mentre nei rimanenti due il vantaggio dei maschi è contenuto. In altre parole, il dato complessivo dei sei dipartimenti mostra una discriminazione verso le femmine, mentre nel dato disaggregato non appare alcuna discriminazione o addirittura si può pensare ad una discriminazione contro i maschi. La spiegazione è nel fatto che i dati precedenti non tengono conto delle scelte dei dipartimenti da parte delle candidate/dei candidati. Le ragazze tendevano ad iscriversi ai dipartimenti piu’ selettivi, nei quali la percentuale di ammissioni era inferiore, mentre i maschi si iscrivevano spesso a dipartimenti in cui era più facile essere ammessi. Un altro esempio in cui la presenza di variabili nascoste porta ad una forma di confondimento e’ il seguente. Durante una riunione di facoltà, un gruppo di insegnanti decise di aver bisogno di capire per gli studenti quale poteva essere la durata ottimale dello studio al fine di ottenere risultati sempre piu’ soddisfacenti. Raccolsero cosi le ore di studio dei diversi studenti e li confrontarono con i punteggi dei loro test. I risultati furono sbalorditivi. Per la confusione di tutti, meno uno studente studiava, più in alto tendeva ad arrivare nei test.

In effetti, il coefficiente associato a questa correlazione e’ di -0.79, una relazione fortemente negativa. Gli insegnanti avrebbero dovuto incoraggiare i loro studenti a studiare di meno? In che modo i dati avrebbero potuto sostenere una simile richiesta? Sicuramente mancava qualcosa.

Dopo aver discusso i risultati, gli insegnanti convennero di consultare lo statistico della scuola che suggerì loro di analizzare i dati di ciascun corso individualmente. Qui la situazione per educazione fisica.

Una correlazione di 0,63! Ecco il paradosso di Simpson. Un fenomeno statistico in cui una relazione apparentemente forte si inverte o scompare quando viene introdotta una terza variabile confondente. Codificando a colori ogni corso separatamente per distinguerli l'uno dall'altro appare questo grafico.

In questo modo gli insegnanti finalmente capirono che più ore uno studente studiava, più il voto tendeva ad essere alto come ci si aspetta. L’Inclusione del corso di studio nell'analisi statistica aveva completamente invertito la relazione iniziale dando un senso cosi a dei dati che inizialmente sembravano segnalare una correlazione spuria. Il paradosso di Simpson e’ molto importante in statistica medica quando si deve indagare l’efficacia di nuovi farmaci o l’impatto di un fattore esterno tipo il fumo delle sigarette sulla salute.

Volendo quantificare l’impatto del fumo sulla salute delle persone, possiamo prendere 2 gruppi (fumatori e non fumatori) e stabilire il numero di decessi in percentuale. Supponiamo che le persone dei due gruppi vengano divisi per fascie di eta’ come mostrato nella tabella seguente.

Calcoliamo il numero di decessi percentuale per i fumatori e non fumatori usando la media ponderata. Per i fumatori abbiamo:

% decessi fumatori= (3.6*(55+62)+2.4(124+157)+…..)/(117+281+….+77)=36.63%

% decessi non fumatori=(1.6*(55+62)+3.1(124+157)+…..)/(117+281+….+77)=25.84%

Fumare allunga la vita? E’ mai possibile? No. L’anomalia sta nel non aver considerata una variabile nascosta importante: l’eta delle persone. Se guardiamo, infatti alle singole fasce ci accorgiamo che su 7 gruppi solo una volta la percentuale di decessi per non fumatori e’ maggiore di quella dei fumatori. Per il restante 85% dei casi invece e’ vero il contrario come ci si aspetta.

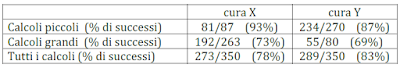

Un altro esempio dal mondo medico. Due cure (X e Y) per il trattamento dei calcoli renali sono state sperimentate su due gruppi di 350 pazienti, con il risultato che la percentuale di successi è stata del 78% per la cura X e dell’83% per la cura Y. Se però si separano i risultati rispetto alla gravità della malattia, la conclusione cambia: si scopre che per i casi gravi la percentuale di successi è stata del 73% per la cura X e del 69% per la cura Y; mentre per i casi non gravi la percentuale di successi è stata del 93% per la cura X e dell’87% per la cura Y.

In altre parole, i pazienti sono stati suddivisi in due gruppi (calcoli piccoli e calcoli grandi); per ciascuno dei due gruppi sembra migliore la cura X, ma se non suddividiamo i pazienti allora, nel gruppo complessivo, sembra migliore la cura Y. Per capire cosa è successo controlliamo innanzitutto i numeri.

che mostrano un fatto aritmetico non molto intuitivo:

Abbiamo quindi otto numeri positivi a, b, r, s, A, B, R, S tali che

È utile visualizzare questo fatto nel modo seguente. Possiamo, ad esempio, vedere la frazione / come il coefficiente angolare della retta che collega l'origine con il punto (, ) nel piano cartesiano. Analogamente / è il coefficiente angolare della retta che collega l'origine con il punto (, ). Infine ( + )/( + ) è il coefficiente angolare della retta che collega l'origine con il punto ( + , + ), cioè con la somma dei vettori (, ) e (, ), ottenuta attraverso la regola del parallelogrammo.

Ora osserviamo che la diseguaglianza A/B>a/b significa che la semiretta che parte dall’origine e passa per il punto (b,a) sta sotto quella che passa per (B,A) e analogamente per gli altri punti. La seconda figura mostra un esempio in cui le tre diseguaglianze A/B>a/b, R/S>r/s, (A+R)/(B+S)<(a+r)/(b+s) sono soddisfatte.

Tornando all’esempio delle cure, non è difficile spiegare cosa è successo. Le consistenze dei quattro gruppi rispetto alla gravità della malattia erano molto diverse: inoltre i medici tendevano a somministrare la cura X (migliore) ai casi più gravi (calcoli grandi) e la cura Y (meno efficace) ai casi meno gravi (calcoli piccoli). Il risultato complessivo è quindi sostanzialmente determinato dai gruppi 2 e 3 nella tabella.

Somministrando la cura X prevalentemente a malati gravi (e la cura Y prevalentemente a malati non gravi), come è stato fatto nello studio in considerazione, si ottiene che l'efficacia globale della cura X è inferiore, e questo potrebbe portare alla discutibile conclusione che la cura X è meno efficace. Concludendo, una correlazione non ci dice assolutamente nulla sui rapporti causali sottostanti. Chi in assenza di esperimenti cerca di dimostrare qualche cosa con un grafico non conosce la statistica o e’ in cattiva fede.