Nell’ultimo decennio, in tutti i campi delle Scienze Ambientali e dei Beni Culturali, è emersa una forte esigenza di metodologie innovative da affiancare a quelle convenzionali per una migliore comprensione dei processi ambientali e antropogenici. Per questo motivo le metodologie isotopiche hanno assunto un ruolo sempre più importante in un numero crescente di procedure di analisi e di controllo sia in campo industriale, che ambientale, biomedico e archeologico. Si tratta, in generale, di metodi di misura sviluppati nella ricerca di base in fisica e trasferiti ai laboratori in vari altri campi. Tra questi metodi la spettrometria di massa di isotopi stabili degli elementi più abbondanti in natura, costituisce un potente mezzo di indagine, largamente utilizzato nelle scienze applicate alla diagnostica dei beni culturali ed ambientali. L’ambiente è, per sua natura, in continua evoluzione ma l’uomo ne ha accelerato il passo in una direzione incognita. Ecco, allora, che la determinazione della composizione isotopica di elementi quali il Carbonio, l’Ossigeno e l’Azoto nell’atmosfera, nel suolo, nella vegetazione e nelle acque, si è dimostrata un indicatore molto sensibile delle piccole variazioni (spesso dovute proprio ad attività antropiche) dei flussi di questi elementi e per studiare meccanismi ancora poco chiari. Gli isotopi sono atomi di uno stesso elemento che posseggono un diverso numero di neutroni. Gli isotopi vengono definiti stabili quando il numero di protoni e neutroni non cambia nel tempo. Poiché i neutroni all’interno dell’atomo sono particelle elettricamente neutre, due isotopi dello stesso elemento mantengono la stessa carica ma hanno un diverso numero di massa (A). Il numero di massa è espresso dalla somma del numero di neutroni (N) e di protoni (Z, particelle cariche positivamente) ed è riportato come apice a sinistra del simbolo chimico. Qui di seguito un diagramma che mostra come la stabilità nucleare è più un’eccezione che una regola con solo 270 nuclidi stabili su 2500 conosciuti.

A causa della diversa massa, gli isotopi di un elemento hanno forze di legame diverse e di conseguenza possono avere comportamenti chimico-fisici diversi. La composizione in isotopi stabili di elementi di bassa massa atomica è riportata in termini di valori relativi ad uno standard di composizione isotopica nota. Questa notazione, il “delta per mille” (δ ‰) è calcolata secondo l’equazione:

dove R indica il rapporto tra l’isotopo più pesante e quello più leggero. In pratica, il valore δ esprime di quante parti per mille il rapporto isotopico si discosta dallo stesso rapporto in uno standard di riferimento con composizione isotopica nota. Il motivo dell’utilizzo di tale notazione risiede nel fatto che la differenza tra due isotopi di uno stesso elemento è molto piccola per cui utilizzare il rapporto R da solo implicherebbe il maneggiamento di numeri con molte cifre decimali e complicherebbe i calcoli. L’uso della notazione δ espande piccole differenze e le rende più facilmente visibili. Inoltre, l’uso di un rapporto di rapporti permette di confrontare elementi diversi che sarebbero molto più difficili da confrontare in valori assoluti.

Un valore δ positivo indica che il rapporto isotopico del campione considerato è più alto di quello dello standard, cioè che il campione è arricchito nell’isotopo pesante rispetto allo standard. Viceversa, un valore δ negativo indica che il rapporto isotopico del campione considerato è più basso di quello dello standard, e quindi che il campione è impoverito nell’isotopo pesante rispetto allo standard. Diversi termini vengono comunemente usati per comparare i valori δ: arricchito/impoverito in isotopi pesanti; più positivo/più negativo; maggiore/minore; più pesante/più leggero.

Esistono diversi standard internazionali di riferimento per vari isotopi (vedi tabella di seguito). Per quanto riguarda gli isotopi stabili dell’acqua (2H e 18O) per esempio, comunemente, lo standard di riferimento è rappresentato dallo VSMOW (Vienna Standard Mean Ocean Water), rimpiazzato nel 2006 dallo VSMOW2 che, per definizione, ha un valore di δ di 0‰.

Le proporzioni relative dei diversi isotopi non sono sempre le stesse a causa del cosiddetto frazionamento isotopico. Questo fenomeno è dovuto a differenze nella velocità di reazione degli isotopi leggeri e pesanti dello stesso elemento durante le reazioni termodinamiche. Nell’acqua, per esempio, il frazionamento isotopico avviene principalmente durante i cambiamenti di fase (evaporazione, condensazione, fusione). In questi casi, la velocità di diffusione varia a seconda della forza dei legami chimici tra gli isotopi pesanti e leggeri. I legami molecolari tra gli isotopi leggeri vengono spezzati più facilmente di quelli tra isotopi pesanti. La forma isotopica pesante dell’acqua (cioè quella contenente 2H e 18O, ossia 2H18O) richiede più energia per spezzare i legami chimici rispetto all’acqua che contiene isotopi più leggeri (1H16O), e di conseguenza la reazione avviene più lentamente. Nel caso del cambiamento di stato da liquido a gassoso, per esempio, le molecole di acqua che contengono 16O evaporano più facilmente rispetto a quelle che contengono 18O, a causa della differenza di massa tra i due isotopi e della facilità di rottura dei legami idrogeno che mantengono l’acqua in forma liquida. Inoltre, maggiore è la differenza di massa tra due isotopi, maggiore è il frazionamento isotopico. Esistono due meccanismi principali che determinano il frazionamento isotopico: frazionamento all’equilibrio e frazionamento non all’equilibrio (frazionamento cinetico). Il primo comporta la redistribuzione degli isotopi di un elemento tra vari composti, cosicché la velocità di reazione diretta e inversa di un certo isotopo è identica. Questo implica che il rapporto tra isotopi differenti in ogni composto o in ogni fase della reazione per una certa temperatura rimanga costante ma non implica necessariamente che la loro concentrazione sia uguale. Durante le reazioni all’equilibrio, l’isotopo più pesante si accumula nel composto col maggiore stato di ossidazione o nel composto più “denso”. Un tipico esempio di processo all’equilibrio è rappresentato dalla condensazione del vapore acqueo. In tale processo, gli isotopi pesanti della molecola d’acqua (18O and 2H) si concentrano nella fase liquida (che così viene definita arricchita in isotopi pesanti) mentre gli isotopi leggeri (16O and 1H) rimangono concentrati nella fase gassosa. In generale, il frazionamento è fortemente dipendente dalla temperatura: più alta è la temperatura, minore è la differenza tra la composizione isotopica di due specie all’equilibrio. Il frazionamento non all’equilibrio è tipico di sistemi aperti, dove il prodotto viene continuamente allontanato dal sistema, o nelle reazioni irreversibili. In questi casi, non è possibile raggiungere l’equilibrio fra reagenti e prodotti. La velocità di reazione è dipendente dal rapporto delle masse isotopiche e dalle loro energie vibrazionali. Come nel caso del frazionamento all’equilibrio, i legami tra gli isotopi leggeri vengono spezzati più facilmente di quelli tra isotopi pesanti. Questo comporta un accumulo di isotopi pesanti nel reagente mentre nelle reazioni reversibili all’equilibrio i prodotti della reazione possono essere isotopicamente sia più leggeri che più pesanti dei reagenti originari. Un tipico esempio di frazionamento isotopico cinetico è rappresentato dal processo di evaporazione dell’acqua dalla superficie degli oceani, in cui il vapore acqueo prodotto dall’evaporazione viene continuamente rimosso dai processi di turbolenza dell’atmosfera cosicché la reazione non può mai raggiungere l’equilibrio. Il vapore prodotto dalla reazione di evaporazione risulta impoverito in isotopi pesanti con una deviazione del rapporto di frazionamento rispetto a quello che avverrebbe all’equilibrio.

Gli isotopi stabili vengono utilizzati per risolvere diversi problemi. Una delle applicazioni più comuni è la geotermometria, cioè la misura di temperature che si sviluppano nel corso dei fenomeni geologici. Il frazionamento isotopico è inversamente proporzionale alla temperatura: il frazionamento è grande alle basse temperature e piccolo alle alte temperature. La geotermometria è inoltre un’analisi geochimica che consente di determinare, indirettamente e attraverso la composizione dei diversi minerali costituenti una roccia, i valori della temperatura alla quale la roccia si è andata formando. Questo metodo si applica se esistono condizioni di equilibrio termodinamico tra i componenti.

Un’altra applicazione degli isotopi stabili è l’identificazione di processi. Le piante, per esempio, che per fotosintesi producono catene di idrocarburi C4 (cioè idrocarburi con 4 atomi di Carbonio) frazionano il carbonio diversamente dalle piante che producono catene di idrocarburi C3. Questo frazionamento è mantenuto nella catena alimentare e quindi la misura di isotopi stabili nelle ossa di mammiferi fossili ci da’ informazioni sulla loro dieta. Le tecniche isotopiche giocano un ruolo importante anche nelle scienze archeologiche, dove sono state utilizzate per stabilire le diete del passato e la migrazione dei popoli, la provenienza di marmi usati in architettura e scultura, la provenienza di antiche ceramiche e metalli, la ricostruzione di paleoclimi e paleoambienti e l’utilizzo di oggetti di terracotta grazie all’analisi dei residui di cibo presenti sulla loro superficie.

Tra gli isotopi usati dagli archeologi quelli più importanti sono:

- carbonio: 13C (o C-13) e 12C (o C-12). Il rapporto tra i due (13C/12C) viene indicato come δ13C

- azoto: 15N (o N-15) e 14N (o N-14). Di nuovo il rapporto (15N/14N) è dato da δ15N.

- ossigeno: 18O (O-18) e 16O (O-16), con il loro rapporto (18O/16O) indicato come δ18O.

- stronzio: 87Sr (Sr-87) e 86Sr (Sr-86). Il rapporto è dato da 87Sr/86Sr.

Per il carbonio le due principali riserve in natura sono rappresentate dal carbonio organico e dai carbonati. Queste sono caratterizzate da differenti impronte isotopiche a causa dei diversi processi in cui sono coinvolte.

Il carbonio inorganico (carbonatico) interviene negli equilibri di scambio tra anidride carbonica atmosferica - ione bicarbonato disciolto - carbonato solido; queste reazioni di scambio portano ad un arricchimento dell’isotopo pesante nella forma carbonatica solida (δ13C pari a 0‰). Viceversa, le reazioni cinetiche in cui risulta principalmente coinvolto il carbonio organico, attraverso i processi fotosintetici, determinano una concentrazione dell’isotopo più leggero nel materiale organico prodotto (δ13C pari a circa −25‰). Il frazionamento del carbonio organico è principalmente legato al tipo di pianta che opera la fotosintesi. Le piante terrestri, classificate come C3 e C4, seguono due vie metaboliche differenti. Entrambe generano sostanza organica caratterizzata da valori di δ13C più negativi rispetto a quello dell’anidride carbonica (~-7‰), in quanto durante la fotosintesi la sostanza organica prodotta accumula l’isotopo leggero rispetto a quello pesante. Le piante C3, caratteristiche dei climi temperati, producono un composto a tre atomi di carbonio (ciclo di Calvin) con un valore medio di δ13C pari a -26,5‰. Le piante C4 generano un composto a 4 atomi di carbonio (ciclo di Hatch-Slack) caratterizzato da un valore di δ13C intorno a -12,5‰. Partendo da questo tipo di conoscenze il frazionamento del carbonio di origine organica è stato indagato per molteplici applicazioni, tra le quali lo studio delle reti trofiche. La composizione chimica dei tessuti animali è connessa alle risorse alimentari che essi assimilano e pertanto i tessuti riflettono la composizione isotopica della dieta. L’arricchimento tra i produttori e i consumatori primari (erbivori) è stato stimato intorno al +5‰ mentre andando ai livelli successivi della catena trofica l’arricchimento risulta meno marcato (+1‰). Il valore isotopico rilevato nei tessuti di un organismo, quindi, può essere utilizzato come indicatore della sua posizione trofica, ma dato che la variazione dei valori di δ13C associata ai passaggi trofici risulta relativamente modesta, questo dato è usato principalmente per rintracciare la fonte primaria di carbonio assunta. Attraverso l’analisi degli isotopi stabili del carbonio è possibile anche differenziare le reti trofiche terrestri da quelle marine. Il carbonio “marino” deriva infatti dal carbonio inorganico disciolto (bicarbonato disciolto) caratterizzato da un valore isotopico pari a circa 0‰, e quindi più alto di quello dell’anidride carbonica atmosferica, che è pari a circa -7‰. Tale differenza è mantenuta ad ogni livello trofico sia in ambiente marino che terrestre.

Passiamo adesso all’azoto. Esso è il principale elemento dell’atmosfera terrestre (circa il 78%), ma nonostante ciò la maggior parte degli organismi non sono in grado di usarlo in forma gassosa. L’azoto atmosferico deve essere quindi convertito in forme utilizzabili e ciò avviene naturalmente attraverso una serie di reazioni chimiche mediate dai microorganismi azotofissatori che vivono sia nel suolo che nelle acque dolci e salate (Clostridium, Azotobacter, Rhizobium leguminosarum, attinomiceti), e che producono un frazionamento isotopico dell’azoto differenziando i valori di δ15N. La prima fase della fissazione è quella che vede la formazione di azoto ammonico (δ15N pari a circa 1‰) da quello molecolare atmosferico.

Le reazioni che generano ulteriori trasformazioni dell’azoto nel suolo e nelle acque sono la mineralizzazione, la volatilizzazione, la nitrificazione e la denitrificazione, anch’esse per la maggior parte mediate da microrganismi. Ad esempio, la volatilizzazione è legata alla perdita di ammoniaca dal suolo all’atmosfera. Tale processo è caratterizzato da un elevato frazionamento che produce ammoniaca impoverita in δ15N, lasciando lo ione ammonio residuo presente nel suolo arricchito dell’isotopo pesante. L’intero processo di trasformazione dell’azoto in nitrato coinvolge diversi passaggi di reazione, ognuno dei quali produce un arricchimento nel substrato azotato residuo che può arrivare al 30‰. La denitrificazione (cioè l’utilizzo del nitrato al posto dell’ossigeno quale substrato per l’ossidazione della materia organica) è un processo mediato da batteri, in grado di provocare un elevato frazionamento isotopico del nitrato residuo. In relazione anche alle condizioni ambientali, l’attività batterica discrimina le forme isotopiche più “leggere”, determinando nel nitrato residuo un arricchimento dell’isotopo pesante rispetto all’azoto molecolare prodotto. Nella figura sottostante vengono riportati i principali processi che interessano il ciclo dell’azoto in ambiente marino.

La conoscenza dell’intero ciclo dell’azoto in termini di distribuzione isotopica, in associazione a quello del carbonio, è utile sia per comprendere le caratteristiche della catena trofica che le relazioni tra alcuni tipi di pressioni antropiche sull’ambiente e gli impatti sugli ecosistemi.

Ora passiamo all’ossigeno. Durante i fenomeni di evaporazione e precipitazione si verifica il frazionamento isotopico dell’ossigeno (e dell’idrogeno). L’entità del frazionamento dipende dalla temperatura e da altri fattori climatici e geografici come ad esempio latitudine, altitudine, stagionalità e continentalità. L’acqua tende ad evaporare con una reazione di equilibrio regolata dalla temperatura. La fase vapore è caratterizzata da un arricchimento in 16O (δ18O < 0) e in 1H, essendo le molecole di 1H16O più leggere e quindi più favorite all’evaporazione. La fase liquida sarà viceversa più ricca in 2H16O, 1H18O e 2H18O, molecole più pesanti (δ18O e δ2H >0).

Le precipitazioni si impoveriscono dell’isotopo pesante all’aumentare della latitudine e dell’altitudine. In una stessa regione, le precipitazioni relative ai mesi freddi sono caratterizzate da composizioni isotopiche negative mentre durante i mesi caldi risultano arricchite in isotopi pesanti (δ più positivi per l’effetto stagionalità). Le precipitazioni risultano infine più arricchite dell’isotopo pesante spostandosi da regioni costiere all’entroterra. Anche nel ciclo vegetativo delle piante, i processi di adsorbimento dell’acqua e di evapotraspirazione determinano un arricchimento degli isotopi pesanti (2H e 18O), in dipendenza dalla specie vegetale e dall’acqua “isotopicamente” diversa che le varie specie vegetali hanno a disposizione per la fotosintesi.

Il quarto elemento anch’esso molto utilizzato dagli archeologi e’ lo stronzio. Esso ha quattro isotopi naturali: 84Sr, 86Sr, 87Sr e 88Sr tutti quanti stabili. Le abbondanze isotopiche sono variabili a causa della formazione del radiogenico 87Sr attraverso il decadimento del 87Rb. Per questo motivo l’esatta composizione isotopica delle rocce dipende dal rapporto iniziale di Rb/Sr durante la fase di cristallizzazione, dall’età della roccia e da quanto 87Sr si è formato, dall’interazione con fluidi o attività metamorfica. Questa quantità rimane inalterata per tutta la vita della roccia, anche quando questa si sgretola andando a formare il terreno dove crescono piante che a loro volta entrano nel ciclo di vita degli erbivori.

Ma come facciamo a misurare quantità cosi esigue di elementi isotopici? Quali apparecchiature possono aiutare l’archeologo o il geologo ad effettuare studi sui rapporti isotopici? La risposta è la spettrometria di massa. Si tratta di una tecnica che viene utilizzata per separare molecole cariche, in base alla loro massa, o più correttamente in base al loro rapporto massa/carica grazie ad un campo magnetico. Quindi è una tecnica in grado di distinguere isotopi dello stesso elemento e di calcolarne i rapporti isotopici. Questi ultimi nel caso degli elementi leggeri (H, O, C, N, S) vengono misurati con la tecnica IRMS (isotope ratio mass spectrometry) mediante trasformazione in gas puri. Per altri elementi, quali ad esempio B, Fe e Sr viene utilizzata invece la tecnica ICP-MS (Inductively coupled plasma-mass spectrometry) che prevede la trasformazione del campione da analizzare in atomi e ioni.

Passiamo adesso a qualche esempio di applicazione nell’ambito archeologico. Una delle attività di ricerca in cui si fa largo uso degli isotopi stabili è quella dello studio dei resti fossili umani ed animali per risalire all’ecologia e alla dieta degli individui investigati e ricostruire le condizioni paleoclimatiche e paleoambientali dei loro habitat. A questo scopo vengono misurati i rapporti isotopici di C, N, S, O e Sr nelle frazioni minerali (carbonato idrossiapatite) e organiche (collagene) di ossa e denti. Questi risultano per vari motivi indicatori delle condizioni ambientali in cui gli organismi sono vissuti e possono fornire informazioni di tipo paleoidrologico, paleoclimatico, sulle diete, sulla disponibilità e qualità del cibo, ecc. Alcuni di questi parametri possono essere utilizzati inoltre per identificare la mobilità e le migrazioni degli individui studiati. Lo scheletro dei mammiferi è costituito da una frazione minerale di carbonato idrossiapatite (bioapatite) e da una struttura di sostegno costituita da fibre di collagene nelle quali sono dispersi i minerali. È stato osservato che entrambi i tessuti sono in grado di “registrare” nella loro composizione isotopica le condizioni dell’habitat. Il δ13C del collagene e della bioapatite deriva principalmente dalla dieta, a sua volta dipendente dalla distribuzione e dalla tipologia delle piante. Il δ15N risulta anche correlato direttamente con l’aridità dell’habitat. Il δ34S risulta invece dipendente anche dal contesto geologico, dato che subisce scarsi frazionamenti durante i vari passaggi della catena trofica, per cui può essere utilizzato per ricostruire la mobilità degli individui, esattamente come il 87Sr/86Sr. Il δ18O della porzione fosfatica (δ18Op) e carbonatica (δ18Oc) della bioapatite è dipendente da tutte le fonti di ossigeno (cibo, acqua, O2 respiratorio, ecc.) ma per il bilancio di massa l’acqua ingerita, essendo in maggiore quantità rispetto alle altre componenti, risulta generalmente responsabile della composizione isotopica del minerale dello scheletro. Prima di eseguire le misure con lo spettrometro di massa vengono utilizzate specifiche tecniche di estrazione per separare i tessuti di interesse. Un secondo esempio è quello dell’utilizzo degli isotopi stabili per determinare la provenienza dei marmi utilizzati nel passato come per esempio quelli mostrati qui di seguito.

La tecnica è stata utilizzata per la prima volta nel 1972, quando Harmon e Valerie Craig proposero l’uso degli isotopi stabili del C e del O per distinguere 170 diversi marmi da quattro cave greche.

Grazie a questi studi gli archeologi sono riusciti ad individuare le principali cave presenti nel mediterraneo al tempo dei romani (vedi mappa a di seguito) e nell’antica Grecia (vedi mappa b di seguito). Chiaramente la tecnica degli isotopi stabili è una di alcune tecniche a disposizione dell’archeologo per stabilire la provenienza del marmo. Solo grazie ad un’analisi comparata del campione è possibile stabilire con certezza la sua cava di provenienza.

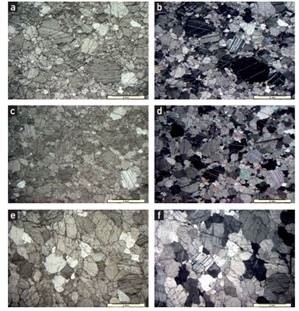

Tra le tecniche maggiormente usate che affiancano l’analisi degli isotopi stabili c’è l’analisi macro e micro-petrografica e la diffrazione a raggi X. Queste tecniche permettono di stabilire le caratteristiche strutturali del campione, i minerali presenti e la tessitura. Nelle immagini seguenti vengono riportate le caratteristiche petrografiche di alcuni marmi osservati con un microscopio polarizzato.

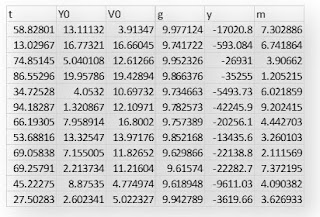

Un’altra possibile applicazione degli isotopi stabili è quella della determinazione della provenienza di oggetti in metallo. In questo caso si usa l’isotopo del piombo i cui studi risalgono al 1970. La provenienza geologica del metallo può essere determinata grazie al frazionamento a cui viene sottoposto il piombo durante i processi metallurgici, come la fusione, raffinazione, lavorazione, colata o corrosione. Il piombo è presente in piccole quantità nel bronzo, nelle monete e in tanti altri oggetti metallici. In natura esiste come 4 isotopi stabili con numero di massa 204, 206, 207 e 208. Per stabilire la provenienza di un oggetto metallica si usa un diagramma del rapporto 206Pb/204Pb verso il rapporto 207Pb/206Pb o 208Pb/206Pb. In questo modo vengono riportati molti dati di miniere di diverse regioni del mediterraneo. Sul diagramma si formano diversi clusters a seconda delle diverse miniere. Qui di seguito un esempio per oggetti in rame da 170 posti del Sud-Ovest dell’Asia. Ci sono alcune punti che si sovrappongono e rendono difficile individuare in maniera univoca la regione della miniera se non si ricorre ad altri metodi.

Una migliore situazione e’ stata ottenuta per esempio per le miniere e oggetti di rame del periodo carcolitico (2900-1800 aC) della Serbia e della Bulgaria dove la sovrapposizione tra i diversi clusters è molto piccola il che si traduce in una migliore precisione del metodo degli isotopi stabili di Pb.