I terremoti sono fenomeni naturali che si verificano continuamente in zone ben precise della crosta terrestre, in relazione a complicati processi di evoluzione del nostro pianeta. Le aree, più frequentemente colpite dai terremoti, sono quelle che si trovano ai limiti delle placche o zolle, in cui è divisa la parte più esterna della terra (litosfera) secondo la teoria della tettonica a zolle. I terremoti avverrebbero proprio ai margini di tali blocchi, in quanto essi si avvicinano, si allontanano, oppure scorrono l’uno accanto all’altro provocando notevoli deformazioni della litosfera fino ad arrivare a delle fratture chiamate faglie, lungo le quali si verificano più facilmente le successive rotture della crosta terrestre (vedi figura 33.1).

Lungo queste fratture si generano intensi rilasci di energia sottoforma di onde meccaniche, definite appunto "onde sismiche". In generale, l’energia durante un terremoto, viene rilasciata tramite una forte scossa principale, per lo più preceduta da piccole scosse premonitrici, dette foreshocks, e seguita da una serie di numerosissime scosse dette aftershocks. Il volume di roccia da cui si origina la frattura e da cui quindi parte la propagazione delle onde sismiche, prende il nome di fuoco. Per semplicità, l’ubicazione della zona sorgente si assimila ad un punto denominato ipocentro; il suo corrispondente sulla superficie terrestre si chiama invece epicentro. I sismologi classificano i terremoti, in base alla profondità del loro ipocentro: superficiali (0-70 km), intermedi (70-300 km) e profondi (300-720 km). I terremoti superficiali sono quelli potenzialmente più distruttivi e pericolosi per gli insediamenti umani. Il meccanismo alla base dei terremoti è stato compreso in seguito alle ricerche del geologo F. Reid ed è da ricercare, come già detto, nelle forze tettoniche che continuano a deformare lentamente le rocce della crosta terrestre lungo le linee di separazione delle placche.

Figura 33.1 Le placche della litosfera (sinistra) e la distribuzione dei terremoti (destra).

Le rocce, che si deformano, immagazzinano energia elastica, proprio come fa un bastone, quando viene incurvato. Quando le forze di legame delle rocce vengono superate, si ha un brusco spostamento delle rocce nel punto più debole della faglia. Il movimento in quel punto (ipocentro del terremoto) provoca istantaneamente una deformazione più in là lungo la faglia, e qui si potrà verificare un ulteriore slittamento; il processo si ripete fino a, quando non si sarà liberata la maggior parte dell’energia elastica immagazzinata. Questo spostamento permette alla roccia deformata di ritornare di colpo alla sua posizione originale, producendo onde sismiche (vedi figura 33.2). Un parametro importante per caratterizzare un terremoto è la sua intensità; questa viene misurata per mezzo di due scale, che prendono il nome dagli scienziati che le hanno sviluppate: Mercalli e Richter. La Scala Mercalli è divisa in 12 gradi d’intensità crescente ed è basata sull’osservazione degli effetti del terremoto partendo da un valore 1 (impercettibile) fino ad un valore 12 (totalmente catastrofico). È opportuno sottolineare che con tale scala si misura l’intensità, cioè esclusivamente gli effetti che un terremoto produce sulle costruzioni, sul terreno e sugli insediamenti umani. La Scala Richter, invece, misura quantitativamente l’energia trasportata dalle onde sismiche secondo una scala che va da valori bassi, anche negativi, fino a valori compresi tra 8 e 9, misurati da appositi strumenti; con questa scala, quindi, si effettua una misura più oggettiva, cioè si calcola la magnitudo. La magnitudo (indicata con M) è una misura dell’energia rilasciata durante un terremoto nella porzione di crosta dove questo si genera.

Figura 33.2 Modello della tettonica a zolle.

I terremoti sono caratterizzati da una fenomenologia molto ricca, che da sempre ha attratto l’attenzione di fisici e matematici che li hanno considerati dei sistemi complessi non facili da analizzare. Questo perchè sia l’ampiezza che il luogo in cui un terremoto si presenta sono intrinsecamente probabilistici.

I sismologi hanno identificato due leggi empiriche che regolano i terremoti. Una è la legge di Gutenberg-Richter, che stabilisce che la frequenza dei terremoti obbedisce ad una legge di potenza rispetto all’energia rilasciata. Questa legge di potenza rende inutile ogni tentativo di distinguere statisticamente i terremoti in base alla loro magnitudo a causa dell’assenza di una scala tipica di energia. La presenza di una legge di potenza per l’energia rilasciata dai terremoti significa che in natura molto spesso i terremoti sono di bassa intensità e raramente solo sono catastrofici. Ma il meccanismo che regola le scosse di bassa intensità è lo stesso di quello che regola le scosse di alta intensità.

L’altra legge è quella di Omori, che stabilisce che il numero di scosse d’assestamento dopo la scossa principale segue una legge di decadimento del tipo:

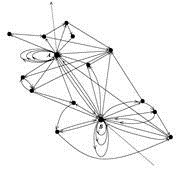

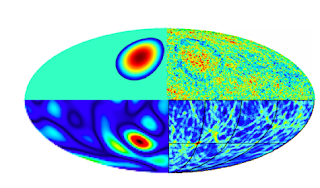

dove p è una costante che varia da 0.5 a 2.5 con un valore tipico vicino ad 1. Questa legge stabilisce che il numero di scosse di assestamento diminuisce rapidamente subito dopo la scossa principale e poi molto lentamente nel tempo. I terremoti mostrano, anche, una struttura frattale sia da un punto di vista spaziale che temporale. Analizzando la distribuzione degli epicentri dei terremoti di particolari regioni della terra come quella mostrata in figura 33.3, i ricercatori hanno verificato che questi tendono a distribuirsi in clusters senza una particolare scala. Coprendo l’immagine della figura 33.3, con un reticolo di lunghezza fissata e colorando i quadratini di nero se in essi cade almeno un punto dell’epicentro di un terremoto, ci si accorge che la distribuzione spaziale originaria non cambia all’aumentare della dimensione dei quadrati del reticolo. A tutte le scale l’immagine che ne risulterà sarà sempre la stessa. Usando le tecniche descritte nel capitolo X, gli scienziati hanno calcolato una dimensione frattale tipica dei terremoti di circa 1.5. Lo stesso discorso vale anche considerando gli intervalli temporali che intercorrono tra i terremoti in un determinato arco temporale. Come si può vedere dalla figura 33.4, la distribuzione temporale dei terremoti con magnitudine maggiore di 6 non è del tutto casuale in quanto c’è un chiaro fenomeno di raggruppamento (clustering). Per capire se anche in questo caso abbiamo una mancanza di scala si può dividere l’asse temporale della figura 33.4, in intervalli temporali di diverse lunghezze come mostrato in figura 33.5. Si nota immediatamente che il comportamento generale della frequenza per una data scala appare simile a quello delle altre scale (invarianza di scala). Quello che è interessante è la ricorrenza dei picchi allo stesso istante su tutte le scale di tempo. Una chiara indicazione di una struttura frattale essendo gli eventi altamente localizzati nel tempo e presenti con una probabilità che è indipendente dalla scala temporale. Per essere più precisi si tratta di una struttura multi frattale, cioè una collezione di monofrattali sovrapposti che dà luogo a degli intervalli temporali più densamente popolati e ad altri meno (vedi figura 33.6). Tutto ciò ha una forte somiglianza con i sistemi complessi in stati critici lontani dall’equilibrio. Poiché l’approccio delle reti complesse si è dimostrato essere un potente mezzo per analizzare le strutture cinematiche e dinamiche dei sistemi complessi, alcuni ricercatori lo hanno applicato anche allo studio dei terremoti. In questo caso la rete viene costruita nel seguente modo. La regione geografica di interesse viene divisa in tante piccole celle di forma cubica. Una cella viene vista come un vertice (nodo) della rete se all’interno di essa si è manifestato un terremoto di qualsiasi magnitudo. Due terremoti successivi definiscono un arco tra due vertici. Se essi capitano nella stessa cella allora l’arco si richiude sullo stesso vertice (loop). Questa procedura rende possibile la mappatura degli eventi sismici tramite un grafo probabilistico dinamico, che chiameremo la rete dei terremoti.

Figura 33.3 Mappa dei terremoti avvenuti in Anatolia tra il 1900 e il 1992.

Figura 33.4 Momento sismico (una grandezza equivalente all’energia rilasciata durante un terremoto) nel tempo (in secondi). Il periodo temporale è 1984-2002. Sono stati considerati solo i terremoti con magnitudine maggiore di 6.

Figura 33.5 Evoluzione temporale degli eventi sismici avvenuti nella regione dell’Anatolia a differenti scale temporali.

Figura 33.6 Metodo per costruire un multi frattale. Si parte col considerare n eventi distribuiti su un intervallo temporale di lunghezza 4, lasciando vuoto il secondo sito. Alla seconda iterazione, la nuova distribuzione è la somma della configurazione per n=1 più una sua versione ingrandita due volte.

In questo modello, gli archi della rete rappresentano la correlazione tra gli eventi sismici (vedi figura 33.7). Dall’analisi di un tale modello emerge la presenza di alcuni nodi che corrispondono alle scosse principali con un numero molto elevato di connessioni (hubs). Ciò è in accordo con quanto scoperto dall’analisi dei dati reali che mostrano che le scosse di assestamento tendono sempre a ritornare nel luogo della scossa principale. Questo è il motivo per cui un nodo che rappresenta una scossa principale tende ad avere un numero elevato di connessioni, cioè tende a diventare un hub. Come mostrato in figura 33.8, la distribuzione delle connessioni segue una legge di potenza del tipo:

dove gamma è una costante positiva. Questo significa che la rete dei terremoti è una rete senza scala (scale-free), in accordo con la legge di Gutenberg-Richter, che stabilisce che la frequenza dei terremoti decade lentamente secondo una legge di potenza rispetto all’energia rilasciata. Dall’analisi della rete dei terremoti è emerso, anche, un rapporto dei coefficienti di clustering che può variare tra 50 e 100 a secondo della dimensione del reticolo utilizzato. Essendo il coefficiente di clustering notevolmente più grande di quello delle reti casuali e poiché la distanza media della rete dei terremoti è molto piccola, questo dimostra in modo inequivocabile che la rete dei terremoti è una rete di piccolo mondo. Per poter andare avanti con l’associazione tra terremoti e reti bisogna introdurre un’altra caratteristica importante delle reti complesse: l’organizzazione gerarchica. Per dimostrare che una rete è organizzata in modo gerarchico va analizzato il coefficiente di clustering in funzione del numero di connessioni di ogni nodo k. Se esso segue una legge di potenza del tipo:

allora la rete ha una struttura gerarchica. Questo è esattamente il caso della rete dei terremoti come si può vedere dalla figura 33.9. La presenza di una struttura gerarchica è molto importante da un punto di vista fisico. Per poterla spiegare, infatti, bisogna assumere che la regola “i ricchi diventano sempre più ricchi” non è vera per tutti i nodi della rete dei terremoti. Alcuni di questi associati a delle faglie attive possono disattivarsi attraverso il processo di rilascio dello stress da parte della faglia e quindi non possono più ricevere nuove connessioni.

Figura 33.7 Rete dei terremoti della California nel periodo 1984-2003.

Figura 33.8 Distribuzione delle connessioni per la rete dei terremoti della California nel periodo 1984-2003. In a è stato usato un reticolo con dimensioni 10x10x10 Km mentre in b un reticolo 5x5x5 Km.

La struttura gerarchica scompare se vengono rimosse le connessioni deboli (per esempio i terremoti con una magnitudo minore di 3).

Figura 33.9 Distribuzione del coefficiente di clustering per la rete dei terremoti della California nel periodo 1984-2003. In (a) è stato usato un reticolo con dimensioni 10x10x10 Km mentre in (b) un reticolo 5x5x5 Km.

La natura scale-free, il fenomeno di piccolo-mondo, la crescita inomogenea delle connessioni e la struttura gerarchica indicano che la rete dei terremoti è molto simile a quella di Internet, anche se differiscono in un punto. Si tratta della proprietà di correlazione delle connessioni. Essa indica qual è la probabilità che un nodo con molti gradi (pochi gradi) sia connesso ad uno con molti gradi o ad uno con pochi gradi. Se questo parametro tende ad aumentare al variare del numero di gradi k allora la rete è detta assortiva mentre se il parametro tende a diminuire la rete è detta disassortiva. Per la rete dei terremoti si trova una correlazione che tende ad aumentare come mostrato in figura 33.10, indicando che i terremoti costituiscono una rete assortiva. Perciò, i nodi con un numero elevato di connessioni tendono ad essere collegati uno all’altro, cioè i nodi che rappresentano terremoti più intensi, tendono ad essere connessi tra loro. Al contrario, Internet, è una rete disassortiva e quindi ha esattamente il comportamento opposto di quello della rete dei terremoti.

Altra caratteristica molto importante dei terremoti e la loro periodicità. Dopo quanto tempo mediamente un terremoto torna nel punto iniziale, cioè nel nodo iniziale della rete dei terremoti? Come mostrato in figura 33.11, la distribuzione dei periodi (che per una rete corrisponde al numero di connessioni Lp da attraversare) segue anch’essa una legge di potenza. Questo implica che ci sono terremoti con periodi molto lunghi, che, da un punto di vista statistico, rendono molto difficile stabilire dopo quanto tempo un terremoto si può ripresenterà in uno stesso luogo. Ciò rende quasi impossibile qualsiasi tipo di previsione.

Oltre all’approccio di rete complessa, i terremoti possono essere modellizzati efficacemente anche utilizzando la cosiddetta teoria SOC (Self-Organized criticality), secondo la quale i sistemi dinamici, lontani dall’equilibrio, possono evolvere spontaneamente verso uno stato critico, per un ampio intervallo di valori dei parametri caratteristici del sistema. Un esempio che illustra il meccanismo SOC è il cosiddetto modello del mucchietto di sabbia o “Sand-pile”. Si tratta di un piatto su cui si fanno cadere dall’alto, uno pera volta, dei granelli di sabbia. Questi granelli si disporranno in una struttura a “pila” di forma conica. Man mano che si aggiungono granelli di sabbia, la pendenza di questo cono aumenterà, fino a raggiungere un valore critico, oltre il quale qualsiasi aggiunta di granelli di sabbia determinerà delle valanghe che andranno a riempire gli spazi rimasti vuoti vicino alla pila di sabbia. Continuando ad aggiungere altra sabbia, il numero di granelli sovrabbonderà e cadrà al di là del piatto. Quando il numero dei granelli persi sarà uguale in media a quello dei grani aggiunti, il mucchietto raggiungerà il suo stato critico. Anche se questo modello è molto semplice, esso si adatta bene a descrivere molti sistemi fisici ed è in grado di generare distribuzioni con legge di potenza che come visto sono molto ricorrenti in natura.

Figura 33.10 Coefficiente di correlazione tra nodi al variare del numero di gradi k.

Gli aspetti fondamentali della teoria della criticità auto-organizzata possono essere cosi riassunti:

- La distribuzione della dimensione delle valanghe segue una legge di potenza

- Le leggi fisiche che regolano l’interazione tra i granelli di sabbia sono molto semplici. In altre parole per auto organizzarsi il sistema non ha bisogno di complicate leggi fisiche

- Le valanghe non avvengono in modo periodico ma in modo imprevedibile

- La superficie del mucchietto di sabbia mostra una struttura frattale

Come è possibile applicare questo modello ai terremoti? Basta ricordare che i terremoti sono associati allo scivolamento delle placche tettoniche lungo le faglie e che le forze tettoniche deformano lentamente le rocce della crosta terrestre lungo le faglie immagazzinando energia.

Figura 33.11 Coefficiente di correlazione tra nodi al variare del numero di gradi k.

Quando quest’ultima supera un valore critico, essa è rilasciata sotto forma di uno scivolamento di un blocco rispetto all’altro coinvolgendo un certo numero di blocchi vicini e dando luogo a “valanghe”. Il modello “sand-pile”, è stato proposto per la prima volta nel 1988 dallo scienziato Per Bak e può essere simulato usando una matrice con nxn celle, ognuna delle quali può interagire con le prime vicine (Nord, Sud, Est, Ovest). Ad ogni cella si attribuisce un valore numerico compreso in un certo intervallo come per esempio tra 1 e 14 e ad ogni numero viene associato un colore che va dal blu al rosso. Inizialmente le celle della matrice vengono forzate ad un valore tra 1 e 14 scelto in modo del tutto casuale (vedi figura 33.12).

Figura 33.12 Simulazione SOC. All’inizio il valore di ogni cella è del tutto casuale.

Si prende a caso una cella della matrice e si incrementa il suo valore numerico (che corrisponde allo stress o energia accumulata dalle rocce) di un’unità: questo processo corrisponde alla caduta di un granello di sabbia nel modello sand-pile ovvero ad un leggero aumento della tensione che si esercita tra blocchi (nel caso dei terremoti) o granelli contigui (nel caso del mucchietto di sabbia). Se il nuovo valore della cella è inferiore ad un valore critico Zc (che possiamo per esempio scegliere essere uguale a 14) allora si procede ad un’aggiunta di granelli altrimenti lo stress viene rilasciato ai primi 4 vicini. In quest’ultima ipotesi, bisogna valutare il valore numerico delle celle vicine e verificare se esso è inferiore o superiore al valore critico. Se è maggiore, allora, si procede analogamente a prima generando una valanga. Al termine di questa valanga, si procede all’aggiunta di ulteriori granelli di sabbia generando cosi ulteriori valanghe. C’è da tener presente comunque, una cosa molto importante. Inizialmente la matrice essendo in uno stato completamente casuale, non si trova in uno stato critico e quindi bisogna generare un certo numero di valanghe per portare il sistema in uno stato di criticità auto-organizzato, a partire dal quale una qualsiasi perturbazione genererà valanghe di differenti grandezze, la cui distribuzione seguirà una legge di potenza. Per determinare quando il sistema raggiunge lo stato critico si può fare nel seguente modo. Si segue la variazione nel tempo del valore medio di tutti gli elementi della matrice <z(t)>, cioè la somma dei valori della matrice diviso il numero totale delle celle e si verifica quando questo valore si porta ad un valore asintotico attorno al quale oscilla. Questo sarà lo stato critico (vedi figura 33.13) del sistema.

Figura 33.13 Simulazione SOC. Andamento del valore medio dei valori delle celle nel tempo.

Per l’esempio scelto, il valore critico è di circa 12.8. Quindi si registrerà una valanga solo se prima di aggiungere un granello di sabbia il valore medio di z è maggiore di 12.8. Facendo partire la simulazione, si osserveranno le diverse valanghe come mostrato in figura 33.14.

Figura 33.14 Simulazione SOC. Formazione delle prime valanghe col trascorrere del tempo.

I vari clusters di punti corrispondono alle celle che vengono interessate durante ogni valanga. Procedendo iterativamente con l’algo-ritmo si possono catalogare diverse valanghe in base alla loro dimensione. Una volta ottenuti questi risultati, si può riportare su scala bi-logaritmica la dimensione delle valanghe e quante volte ogni dimensione si è presentata (frequenza). La parte lineare di questo grafico segue una legge di potenza con un esponente uguale a circa -1 (vedi figura 33.15).

Ovviamente, la stessa simulazione può essere fatta anche partendo con una matrice iniziale non casuale ma con le celle in uno stato ben definito come mostrato in figura 33.16. In questo caso le celle centrali sono cariche di stress. Se si aggiungono a questa matrice altri grani, essa inizialmente conserva il ricordo della condizione iniziale, ma dopo un pò di tempo la tensione di stress accumulata al centro della matrice comincia a distribuirsi in modo eguale su tutti i siti. Dopo 500000 valanghe, la matrice si porta in uno stato di criticità auto organizzata, ed assume un aspetto simile a quello mostrato in figura 33.17.

Figura 33.15 Simulazione SOC. Legge di potenza.

Figura 33.16 Simulazione SOC. Celle centrali in uno stato critico.

Figura 33.17 Simulazione SOC. Stato finale della matrice della figura 33.16 dopo 500000 valanghe.

Questo risultato conferma l’ipotesi della teoria SOC, secondo cui il sistema lontano dall’equilibrio, indipendentemente dallo stato iniziale, si auto-organizza ed evolve verso uno stato critico. Anche per questa simulazione si può analizzare la distribuzione della dimensione delle valanghe, ottenendo per l’esponente della funzione potenza esattamente lo stesso valore precedente, cioè circa -1. Il grafico come quello mostrato in figura 33.15, riproduce qualitativamente la legge di Gutenberg-Richter dei terremoti. Nonostante la semplicità del modello SOC, se si variano opportunamente i pochi parametri della simulazione, è possibile ottenere diverse dinamiche con proprietà differenti. Che dire. Ancora una volta la matematica alla base di un semplice modello riesce a replicare il comportamento dei terremoti e di altri sistemi dinamici presenti in Natura. Delle semplice regole, e un numero elevato di parti connesse (interagenti) sono gli ingredienti giusti per dar vita a strutture complesse il cui comportamento non è prevedibile analizzando le sue parti.