Appunti di viaggio di un fisico curioso...... della bellezza di tutto quello che ci circonda,dell'irragionevole efficacia della matematica nello spiegare il mondo intorno a noi, della continua lotta della vita tra ordine e caos, curioso dell'emergenza della complessita' da regole elementari e tant'altro....... Sara' un viaggio divertente e spero ricco di sorprese.

venerdì 10 maggio 2019

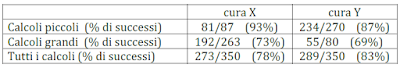

Paradossi della statistica

venerdì 12 aprile 2019

All’ombra del mastodontico mostro …..

martedì 22 gennaio 2019

Archeocarpologia

martedì 11 dicembre 2018

Se tu sei cosi brillante perche’ non sei anche ricco? Questione di fortuna.

Le persone di maggiore successo non sono sempre quelle piu’ talentuose, ma solo quelle piu’ fortunate. Questo il risultato di un modello di ricchezza sviluppato da 3 fisici italiani dell’Universita’ di Catania e pubblicato su Arxiv (Link1, Link2). La distribuzione della ricchezza come noto, segue un pattern ben definito chiamato la regola 80:20 (o principio di Pareto), l’80% della ricchezza e’ posseduta dal 20% delle persone. In uno studio pubblicato l’anno scorso addirittura e’ riportato che solo 8 persone posseggono la ricchezza totale di quella dei 3.8 miliardi di persone piu’ povere al mondo. Questo sembra accadere in tutte le societa’ e a tutte le scale. Si tratta di un noto pattern chiamato legge di potenza che appare in un ampio intervallo di fenomeni sociali. Ma la distribuzione della ricchezza e’ quella che genera piu’ controversie a causa dei problemi che solleva sull’equita’ e sul merito. Perche’ mai solo una piccola parte di persone nel mondo dovrebbe possedere tanta ricchezza? La risposta tipica a questa domanda e’ che noi viviamo in una societa’ meritocratica dove le persone vengono premiate in base al loro talento, intelligenza, sforzi, ostinita’. Nel tempo, questo si traduce nella distribuzione di ricchezza che osserviamo nella realta’. C’e’ un problema pero’ con questa idea: mentre la distribuzione della ricchezza segue una legge di potenza (distribuzione di Pareto), la distribuzione dell’intelligenza e delle abilita’ in genere segue una distribuzione normale che e’ simmetrica rispetto al valore medio. Per esempio, l’intelligenza che viene misurata tramite il test IQ, ha un valore medio di 100 e si distribuisce in modo simmetrico rispetto a questo valore. Nessuno ha mai ottenuto 1000 o 10000. Lo stesso e’ vero per lo sforzo che puo’ essere misurato in ore lavorate. Qualche persona lavora piu’ ore della media e qualche altra di meno, ma nessuno lavora milioni di ore piu’ di altri.

Eppure quando si tratta dei premi che si possono ricevere per il lavoro, alcune persone ottengono ricompense milioni di volte piu’ remunerative di altri. Per di piu’, diversi studi hanno mostrato che in genere le persone piu’ ricche non sono quelle piu’ talentuose. Quali fattori, allora determinano il modo in cui gli individui diventano ricchi? E’ possibile che il caso giochi un ruolo maggiore di quello che ognuno di noi si aspetta? E come possono questi fattori, qualunque essi siano, essere sfruttati per rendere il mondo un posto migliore e più giusto dove vivere?

Una risposta viene proprio grazie al lavoro di A. Pluchino e 2 suoi colleghi dell’Universita’ di Catania. Questo team ha creato un modello al computer utilizzando NetLogo un ambiente di programmazione a multi-agenti. Grazie ad esso hanno potuto analizzare il ruolo del caso in un processo in cui un gruppo di persone con un certo talento esplora le opportunita’ della vita. I risultati sono veramente illuminanti. Le loro simulazioni riproducono accuratamente la distribuzione della ricchezza nel mondo reale. Ma gli individui piu’ ricchi non sono quelli piu’ talentuosi (sebbene essi abbiano comunque un certo livello di talento). Essi sono semplicemente i piu’ fortunati. E questo ha un’implicazione significativa sul modo in cui le societa’ possono ottimizzare i ritorni degli investimenti che si fanno, dal mercato alla scienza. Il modello sviluppato e’ abbastanza semplice. Esso consiste di N persone, ognuna con un certo livello di talento (abilita’, intelligenza, destrezza e cosi via). Questo talento e’ distribuito secondo una Gaussiana intorno ad un valore medio e una certa deviazione standard. Alcune persone, quindi sono piu’ talentuose della media ma nessuna lo e’ per piu’ ordini di grandezza.

Questa e’ la stessa distribuzione che ritroviamo per caratteristiche umane come l’altezza e il peso. Alcune persone sono piu’ alte o piu’ basse della media, ma nessuno ha le dimensioni di un moscerino o di un elefante. Alla fine siamo abbastanza simili tra noi. Il modello costruito, ha seguito ogni individuo per 40 anni di vita lavorativa (dai 20 ai 60 anni). Durante questo tempo, gli individui possono aver sperimentato degli eventi fortuiti che hanno potuto sfruttare per aumentare la loro ricchezza se abbastanza talentuosi. Allo stesso modo, possono anche subire degli eventi sfortunati che possono ridurre la loro ricchezza. Questi eventi sono completamente casuali. Alla fine dei 40 anni, il team ha fatto un ranking degli individui in base alla ricchezza accumulata e studiato le caratteristiche di questa distribuzione. Hanno poi ripetuto la simulazione molte volte per verificare la robustezza dei risultati.

In questa figura un esempio di configurazione iniziale di una simulazione. Ci sono 1000 individui (agenti) con diversi gradi di talento e distribuiti in modo casuale all’interno di un mondo quadrato fatto di 201x201 striscie con condizioni al contorno periodiche. Durante ogni simulazione che copre diverse dozzine di anni queste persone vengono esposte ad un certo numero di eventi fortunati (cerchi di colore verde) e sfortunati (cerchi di colore rosso) che si muovono attraverso il mondo quadrato con traiettorie del tutto casuali.

La distribuzione della ricchezza che emerge dalle simulazioni e’ esattamente quella vista nel mondo reale. La legge 80:20 viene rispettata, in quanto l’80% della popolazione possiede il 20% del capitale totale, mentre il rimanente 20% possiede l’80% di questo capitale. Questo risultato non sarebbe sorprendente o sleale se il 20% delle persone piu’ ricche fosse anche quello piu’ talentuoso. Ma questo non e’ quello che emerge dallo studio.

Gli individui piu’ ricchi, in genere non sono quelli piu’ talentuosi o prossimi a essi. Il massimo successo non coincide con il massimo talento e viceversa.

Quindi se non e’ il talento, quali altri fattori causano questa distribuzione di ricchezza fortemente scodata? La simulazione chiaramente individua nella pura fortuna tale fattore. Facendo una classifica degli individui secondo il numero di eventi favorevoli e sfavorevoli subiti nei 40 anni di lavoro, e’ evidente che gli individui con maggiore successo sono anche i piu’ fortunati. E quelli che hanno avuto meno successo sono proprio quelli piu’ sfortunati (maggiore numero di eventi negativi).

Questo risultato ha delle implicazioni molto profonde per la societa’. Quale e’ la strategia piu’ efficace per esplorare il ruolo della fortuna nel successo di una persona? Il team ha verificato questo aspetto usando il metodo con cui vengono stabiliti i fondi per la ricerca scientifica. Le agenzie di finanziamento di tutto il mondo sono interessate a massimizzare il loro ritorno sull'investimento nel mondo scientifico. Recentemente l’European Reserch Council ha investito 1.7 miliardi di dollari in un programma per studiare la serendipita’, cioe’ il ruolo della fortuna nelle scoperte scientifiche, e come essa puo’ essere sfruttata per migliorare i risultati del finanziamento. E questo studio di Pluchino e il suo team ben si presta a dare una risposta a questa domanda. In esso vengono esplorati diversi modelli di finanziamento per capire quale di essi produce il miglior ritorno quando si tiene in considerazione la fortuna. In particolare sono stati studiati 3 modelli in cui il fondo e’ distribuito equamente a tutti gli scienziati, distribuito a caso ad un numero limitato di scienziati o dato preferenzialmente a quelli che hanno avuto piu’ successo in passato. Quale e’ la migliore strategia? La risposta e’ controintuitiva ed il primo modello. Si avete capito bene quella che assegna il fondo in modo equo a tutti gli scienziati. E subito dopo la seconda e terza strategia vincente e’ quella che prevede di assegnare a caso il fondo al 10 o 20% degli scienziati. In questi casi, i ricercatori riescono ad ottenere un vantaggio dalle scoperte per serendipita’ che avvengono nel tempo. Col senno di poi e’ ovvio che se uno scienziato ha fatto una scoperta nel passato non significa che ha una probabilita’ maggiore di farne un’altra nel futuro. Un simile approccio potrebbe essere applicato anche negli investimenti di altro tipo di aziende, come una piccola o grande impresa, startup tecnologiche o anche per la creazione casuale di eventi fortunati. E’ chiaro che c’e’ bisogno di ulteriori indagini e studio su questo argomento prima di poter dare un giudizio definitivo. I primi risultati sono di sicuro rivoluzionari e in controtendenza, con una prospettiva di applicazione del tutto nuova e molto interessante. Non ci resta che aspettare ulteriori dettagli….

domenica 2 dicembre 2018

L’Universo dopo la missione Planck

Sono ormai 50 anni da quando abbiamo scoperto un fondo di microonde che arriva sulla terra proveniente da tutte le regioni del cielo. Queste radiazioni non provengono dal sole, da galassie o altre stelle ma sono la luce residua del Big Bang che oggi chiamiamo radiazione cosmica di fondo detta anche semplicemente radiazione di fondo e indicata con l’acronimo inglese CMB. Le missioni satellitari realizzate negli anni passati hanno avute tutte lo scopo di studiare le caratteristiche principali di tale radiazione e verificarne l’accordo con le previsioni teoriche. L’ultima di queste missioni ha visto impegnato il satellite Planck dell’agenzia spaziale europea, lanciato nel 2009. Grazie ad esso la nostra visione dell’Universo e’ cambiata radicalmente. Vediamo perche’. L’immagine seguente mostra come la temperatura associata all’energia di questa radiazione fossile, 380000 anni dopo il Big Bang, non e’ uniforme in tutte le direzioni dello spazio in quanto mostra delle piccole variazioni dell’ordine delle centinaia di microkelvin (il colore blu indica temperature piu’ basse e quello rosso temperature piu’ alte).

Per analizzare l'origine della radiazione cosmica di fondo è necessario tornare al periodo conosciuto come era della ricombinazione. Nell'Universo le condizioni cominciano a permettere la formazione di atomi di idrogeno, fenomeno detto appunto ricombinazione. L'energia di ionizzazione dell'idrogeno vale 13,6 eV, e dunque basta questa energia per staccare l'elettrone dal nucleo, ma a quel tempo la maggior parte dei fotoni possiede ancora un'energia maggiore di quel valore. Quindi ogni volta che un fotone interagisce con un atomo appena formatosi, quest'ultimo perde il proprio elettrone. Il fotone viene deflesso e questa interazione è descritta dal fenomeno chiamato scattering Thomson (figura seguente), responsabile dell'aspetto opaco dell'Universo di allora.

Per questo motivo il cammino libero percorso dai fotoni tra una collisione e l'altra è estremamente breve e impedisce appunto la formazione di atomi stabili. Con il passare del tempo però l'Universo si espande, la temperatura cala e di conseguenza anche l'energia dei fotoni diminuisce, facendo decrescere sempre più il numero di essi in grado di ionizzare gli atomi di idrogeno. Al termine di questo processo si hanno gli elettroni nel loro stato fondamentale e i fotoni ormai non più in grado di interagire con essi. Cessa dunque il fenomeno di scattering e l'Universo passa da uno stato opaco ad uno trasparente. Si parla quindi di disaccoppiamento tra materia e radiazione, perché da questo momento in poi i fotoni sono liberi di propagarsi in moto perenne nell'Universo, senza essere più deflessi, costituendo ciò che oggi è conosciuta appunto come radiazione cosmica di fondo. Importante notare come ricombinazione e disaccoppiamento sono fenomeni distinti e non avvengono contemporaneamente. A partire dal 1983 sono stati condotti diversi esperimenti per ottenere più informazioni, tra cui soprattutto l'effettiva temperatura dei fotoni della radiazione cosmica di fondo. Sono tre le missioni spaziali più famose a questo riguardo: COBE, acronimo di Cosmic Background Explorer, del 1992, WMAP, ovvero Wilkinson Microwave Anisotropy Probe, del 2001 e Planck, lanciato nel 2009. Quest'ultima nasce con gli obiettivi di misurare con grande precisione il CMB, osservare strutture dell'Universo come alcuni ammassi di galassie, studiare l'effetto chiamato lente gravitazionale e stimare i parametri osservativi. Questi obiettivi, uniti alla tecnologia utilizzata nella realizzazione dell'esperimento, rendono questa missione la più importante delle tre. Grazie ai dati raccolti, soprattutto da Planck, si sono fatti importanti passi avanti in questo campo. Oggi si sa infatti che la radiazione cosmica di fondo corrisponde esattamente alla radiazione emessa da un corpo nero, a una temperatura

T0 = 2.725+/- 0.001 K

a cui corrisponde un’energia media di questi fotoni di solo 1.126*10-22 Joule. Un corpo nero è, fisicamente parlando, un radiatore ideale, ovvero un ggetto che assorbe ogni tipo di radiazione elettromagnetica da cui viene colpito, senza riflettere energia. Il principio di conservazione dell'energia tuttavia non permette di assorbire semplicemente energia e quindi un corpo nero riemette tutta l'energia che ha ricevuto sotto forma di radiazione. Le missioni COBE e WMAP hanno confermato le ipotesi che erano state fatte sul CMB. È stato infatti dimostrato come lo spettro della radiazione cosmica di fondo corrisponda esattamente a quello di un corpo nero.

Il satellite Planck ha misurato le fluttuazioni in temperatura con una risoluzione che nessun altro satellite prima aveva fatto: circa 5 microkelvin rispetto ai 70 di COBE. Quest’alta risoluzione insieme alla capacita’ di misurare la polarizzazione di questa luce ci ha permesso di capire, misurare ed eliminare gli effetti della polvere (vedi immagine seguente) presente nella nostra galassia meglio di quanto fatto prima. Per ottenere le informazioni cosmologiche contenute in questo fondo e’ necessario conoscere tutti gli effetti che possono contaminare tale segnale.

Una volta che il segnale e’ stato ripulito esso puo’ essere analizzato per estrarre tutta l’informazione possibile. Questo significa usare le fluttuazioni in temperatura su larga, intermedia e piccola scala per cercare di capire:

· quanta materia normale, oscura ed energia oscura ci sono nell’universo

· la loro distribuzione iniziale

· la forma e curvatura dell’universo (vedi immagine seguente)

E’ possibile anche analizzare le diverse varieta’ di luce polarizzata di questa radiazione e ottenere altre informazioni molto utili per gli scienziati. Grazie a Planck adesso conosciamo alcuni dei parametri cosmologici con una maggiore precisione, come per esempio la costante di Hubble che oggi sappiamo essere un numero tra 67 e 68 Km/s/Mpc.

L’universo ha piu’ materia e si sta espandendo piu’ lentamente di quanto pensavamo prima. Prima dei risultati del satellite Planck, si pensava che l’universo fosse costituito per il 26% di materia e 74% di energia oscura con un tasso di espansione intorno a 70 Km/s/Mpc. Adesso invece la quantita’ di materia nell’universo corrisponde a circa il 31.5% (il cui 4.9% e’ materia normale e il rimanente materia oscura) mentre il 68.5% e’ energia oscura con una costante di Hubble di circa 67.4 Km/s/Mpc. Quest’ultima e’ in contrasto con altre misure che invece indicano un rate di 73 Km/s/Mpc. Questo punto e’ probabilmente una delle poche controversie ancora oggi rimanenti sul modello di universo. Grazie al satellite Planck sappiamo che ci sono solo 3 tipi di neutrino e la massa di ognuno di essi e’ non piu’ di 0.04 eV/c2, circa 10 milioni di volte meno massiccia di un elettrone. Un’altra indicazione e’ quella che l’universo e’ realmente piatto e la sua curvatura e’ non piu’ di 1 parte su 1000. A partire dall’intensita’ di questa radiazione di fondo e’ possibile utilizzare la trasformata di Fourier per ottenere lo spettro continuo delle fluttuazioni di temperatura. Per descrivere la distribuzione spaziale dell’intensita’ e quindi della temperatura si puo’ sfruttare il fatto che queste sono distribuite su una superficie sferica e quindi e’ possibile utilizzare una decomposizione in armoniche sferiche:

dove Yl,m e’ la funzione armonica sferica di grado l ed ordine m. Di seguito lo spettro ottenuto da Planck.

Esso tra le altre cose ha fornito anche una conferma della teoria dell’inflazione cosmica. Quest’ultima prevede che le fluttuazioni dell’universo al suo inizio dovrebbero essere pio’ o meno le stesse a tutte le scale con una piccolissima maggiore fluttuazione alle scale piu’ grandi. In accordo con i dati forniti da Planck questo significa che una delle quantita’ cosmologiche chiamata indice spettrale ed indicata con ns e’ prossima ad 1 (Planck da’ 0.965+/-0.05%) come ci si aspetta dalla teoria dell’inflazione. C’e’ anche un’altra questione a cui le misure di Planck possono dare un contributo. L’energia oscura che e’ estremamente sensibile alla radiazione di fondo e ai dati provenienti dall’universo ultra-distante (come le supernove di tipo Ia) e’ o no una costante cosmologica? Nel caso in cui lo fosse allora la sua equazione di stato indicata col parametro w dovrebbe essere esattamente pari a -1. Cosa dice Planck? Si e’ trovato un valore di -1.03 con una incertezza di solo 0.03.

Dopo la missione Planck, anche altre quantita’ hanno mostrato delle differenze anche se molto piccole. L’universo e’ diventato leggermente piu’ vecchio. Siamo a 13.8 miliardi di anni verso i precedenti 13.7 miliardi di anni. La distanza del confine osservabile dell’universo e’ un po’ piu’ piccola di quanto pensavamo: 46.1 invece di 46.5 miliardi di anni luce.

In definitiva possiamo dire che in base ai risultati del satellite Planck:

· il modello dell’inflazione e’ confermato

· esistono tre specie di neutrini

· l’universo si sta espandendo piu’ lentamente di quanto pensavamo prima e non c’e’ alcuna evidenza di una sua curvatura

· c’e’ un po’ piu’ materia oscura e materia standard di quanto pensavamo prima a scapito di un po’ meno di energia oscura.

· non c’e’ alcuna evidenza a favore dei modelli Big Rip e Big crunch dell’universo

Grazie alla missione Planck oggi abbiamo uno spettacolare accordo tra la radiazione di fondo (CMB) e le previsioni teoriche dell’universo contenente 5% di materia normale, 27% di materia oscura e 68% di energia oscura. Ci puo’ essere la possibilita’ di variazioni del 1-2% per questi valori, ma un universo senza materia oscura e senza energia oscura con i dati in nostro possesso non e’ pensabile. Entrambe sono reali e necessarie (vedi linea blu del grafico precedente per capire il buon accordo tra i dati teorici che prevedono la materia e l’energia oscura e i dati sperimentali rappresentati dai punti in rosso ottenuti da Planck).

Per approfondire: