Il tasso di morte per carcinoma al seno nella popolazione femminile e’ molto alto (28% dei tumori femminili) e in Italia e’ la prima causa di morte nella fascia tra i 35 e 50 anni. Secondo la World Health Organization, il cancro al seno colpisce piu’ di 1.5 milioni di donne al mondo. La prima testimonianza di un cancro al seno e’ quella di una donna egizia del 1600 a.C. morta a causa di questa malattia. Contrariamente a quanto si pensa oggi il cancro non e’ una malattia del nostro secolo.

Il rischio per una donna di ammalarsi di tumore al seno e’ del 10-12% e varia in base all’eta’:

· fino a 49 anni à 2.4% (1 donna su 42)

· tra i 50 e i 69 anni à 5.5% (1 donna su 18)

· tra i 70 e gli 84 anni à 4.7% (1 donna su 21)

Data l’elevata incidenza ed il tasso di mortalita’ negli ultimi anni sono stati adottati degli screening ben precisi e definiti per identificare precocemente la patologia. Le evidenze scientifiche dimostrano come la diagnosi precoce sia l’azione piu’ efficace nella lotta contro il tumore della mammella.

Le tecniche diagnostiche piu’ indicate per questa malattia sono l’ecografia, la mammografia, agoaspirato, TAC, PET e RNM. In caso di nodulo al seno, la diagnosi e’ quindi un primo fondamentale passaggio. Una tardiva o non corretta diagnosi della patologia potrebbe infatti portare, nei casi piu’ gravi al decesso della donna. Nonostante i progressi scientifici fatti in ambito medico purtroppo in assoluto non e’ possibile escludere che si possano verificare degli errori medico-sanitari anche durante la fase diagnostica. Questi errori per esempio possono derivare da difetti del macchinario, procedure non seguite scrupolosamente, scambio di analisi, esami mal letti o interpretati, mancato approfondimento con ulteriori visite o esami integrativi. Per questo motivo con l’avvento dell’intelligenza artificiale si e’ pensato di affiancare al medico degli oracoli digitali per riconoscere alcune forme di tumore. Numerosi ricercatori hanno pensato di applicare le tecniche proprie del machine learning per identificare il carcinoma al seno e non solo.

Immagine ecografica di un cancro al seno Immagine mammografica di cancro al seno

Negli ultimi anni, una grande quantita’ di dati relativi al tumore del seno sono stati collezionati e resi disponibili sul web in diveri siti (vedi come esempio UCI). Tra questi database c’e’ quello dell’Universita’ del Wisconsin utilizzato in questo post. E’ un classico database per l’applicazione di algoritmi di classificazione binaria per il machine learning. E’ composto da 569 esempi o istanze, 31 predittori o features e una risposta che in questo caso e’ una variabile binaria con due valori: benigno B e maligno M. Ci sono 357 casi di tumore benigno e 212 di tumore maligno. Le due classi sono abbastanza bilanciate con un rapporto del 60%.

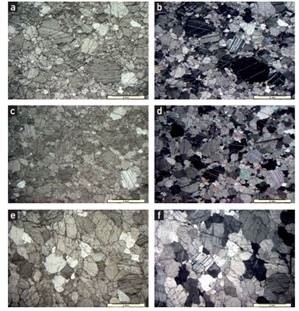

Le variabili x (i predittori o features) sono state registrate utilizzando delle immagini digitali della massa tumorale catturata con la tecnica dell’ago aspirato. In effetti le variabili sono 10, ma diventano 30 in quanto e’ stato preso il valore medio, la standard deviation e il valore massimo. Si tratta di 10 misure tutte relative ai nuclei delle cellule tumorali (vedi immagine di seguito).

6. Concavita’

7. Punti di concavita’. Diversamente dalla concavita’ questo parametro determina quanti punti di concavita’ ci sono.

8. Simmetria misurata tracciando l’asse maggiore passante per il centro e poi facendo la differenza della lunghezza tra linee perpendicolari all’asse maggiore in entrambe le direzioni.

9. Dimensione frattale ottenuta approssimando la linea chiusa con la “linea di costa” descritta da Mandelbrot.

10. Texture ottenuta trovando la varianza dell’intensita’ della scala dei grigi nei pixels

Per questo studio e’ stato utilizzato JMP Pro 16 della SAS che contiene una serie di algoritmi di machine learning utilizzabili per scopi di classificazione supervisionata. Tra i modelli disponibili abbiamo: Decision tree, Random Forest, Boosted tree, Logical regression, Support Vector Machine, Naive Bayes, XGboost, kNN, Neural Network (per maggiori dettagli sui diversi modelli di machine learning fare riferimeno al post “Alla scoperta delle leggi della fisica con il machine learning” su questo blog). Prima di iniziare, controlliamo le distribuzioni delle nostre features che risultano tutte leggermente skewed sulla destra (mostrano cioe’ una leggera coda verso gli alti valori). Non ci sono valori mancanti nel database e solo alcuni outliers.

Il training per questo dataset e’ stato fatto su 8 classificatori usando l’opzione 5-fold cross validation. Per stabilire il grado di accuratezza e l’efficacia di qualsiasi modello di machine learning e’ necessario eseguire una o piu’ valutazioni sugli errori che si ottengono con ogni previsione. In genere, dopo il training viene effettuata una stima dell’errore per il modello, meglio nota come valutazione dei residui. Si tratta della stima numerica della differenza tra la risposta prevista e quella originale, chiamata anche errore di addestramento (training error). Tuttavia questo non basta in quanto non da’ un idea di quanto il nostro modello riuscira’ a generalizzare in caso di nuovi dati. Per questo motivo viene utilizzata la valutazione incrociata. Essa consiste nella suddivisione dell’insieme di dati in k parti (5 nel nostro caso) di uguale numerosita’ e a ogni passo la k-esima parte dei dati viene usata come convalida, mentre la restante parte costituisce l’insieme di training (addestramento). In questo modo si allena il modello per ognuna delle k parti evitando problemi di overfitting (sovradattamento) ma anche di campionamento asimmetrico (distorsione) tipico della suddivisione dei dati in due sole parti.

Per stabilire quanto un modello e’ bravo nella classificazione esistono diverse metriche. Quelle piu’ usate sono legate al concetto di matrice di confusione. La nostra risposta puo’ avere solo due possibili valori M e B. Quindi accoppiando le risposte del modello e quelle effettive possiamo avere la seguente matrice:

A=1-ME=1-((FN+FP)/(FN+FP+TN+TP))

Osserviamo che come ci si aspetta se l’errore e’ nullo allora l’accuratezza sara’ massima e cioe’ 1. Nel caso invece in cui l’errore e’ massimo e cioe’ 1 allora l’accuratezza del modello e’ pari a zero. Un’altra metrica e’ la Precisione P del modello che indica l’abilita’ di un classificatore di non etichettare un’istanza positiva che in realta’ e’ negativa.

P=TP/(TP+FN)

Altre metriche utilizzate da JMP Pro per i classificatori sono l’R2, il RASE e l’AUC. Trattandosi di un classificatore che lavora su dati categorici per la risposta ci si chiede come e’ possibile che JMP restituisca il valore del R2 che tutti associamo alle regressioni numeriche? E la stessa domanda nasce anche quando le X sono categoriche. Un algoritmo dopo tutto e’ una sequenza di operazioni matematiche. Ma come si fa a sommare due variabili nominali quali Benigno e Maligno?

In questo modo e’ possibile calcolare il valore del R2 essendo adesso le variabili tutte numeriche. Allo stesso modo e’ possibile calcolare il cosiddetto RASE, cioe’ la radice quadrata del valore medio dell’errore (y-ya) al quadrato (ya e’ il valore effettivo e y quello previsto dal modello). L’AUC indica invece l’area al di sotto della curva ROC. Vediamo di cosa si tratta. In qualsiasi problema di classificazione, il modello genera per ogni record un valore di probabilita’ di appartenenza ad uno dei 2 gruppi. Per decidere quindi se un record appartiene ad una classe piu’ che ad un’altra, e’ importante stabilire un valore di soglia per la probabilita’. Ovviamente al variare di tale soglia cambiera’ l’output del modello e la relativa matrice di confusione. Per stabilire se un modello sta lavorando bene si puo’ utilizzare la curva di ROC. Sull’asse della x viene riportato il numero di falsi positivi (FP) o 1-SPE dove SPE=TN/(TN+FP) e’ la cosiddetta Specificita’, mentre sull’asse delle y viene riportata la quantita’ TP/(TP+FN) che in modo indiretto e’ legata al numero di falsi negativi (quando FN e’ zero infatti questo rapporto vale 1). Il migliore modello di classificazione sara’ quello che ottiene FP=0 e FN=0, che nel piano della curva ROC corrisponde al punto x=0 e y=1. I due plot ROC seguenti si riferiscono al caso della rete neurale per il set di Training e di Validation. I colori rosso e blu indicano i due valori della classe di risposta: Benign e Malignant. L’AUC come indica l’acronimo e’ il valore dell’area al di sotto della curva ROC. Piu’ e’ prossimo ad 1 e meglio e’ la prestazione del modello.

L’accuratezza di tutti i modelli testati con il comando Model Screening di JMP e’ ben al di sopra del 90%, il che significa che il massimo errore per mis-classification e’ minore del 10%. L’algoritmo del Neural Boosted addirittura mostra un errore del solo 1%. Non c’e’ che dire, l’oracolo digitale sembra fare delle ottime previsioni. Attenzione. Anche se nella lingua inglese non c’e’ una grossa differenza tra prediction e prevision (o forecast) questo non e’ vero in italiano. Nella nostra lingua la predizione e’ quella fatta da un mago che cerca di capire cosa accadra’ nel futuro aiutandosi con strumenti che di scientifico non hanno praticamente nulla (e quindi fallira’ miseramente). Al contrario la previsione e’ quella che cerca di capire cosa puo’ succedere utilizzando metodi scientifici (matematici, fisici, statistici) come la previsione del ritorno della cometa di Halley o la probabilita’ che il costo delle azioni Apple crescera’ nei prossimi giorni.

Ritorniamo ai modelli testati. Il migliore e’ la rete Neurale Boosted. Ma cosa significa boosted? E’ una classe di modelli nati nel 1988 con l’idea che mettendo insieme piu’ modelli di apprendimento deboli si possa creare un modello piu’ forte (della serie che l’unione fa la forza). Si tratta di un modello iterativo (lavora in seriale) che stabilisce come collegare tra loro un insieme di weak learner per crearne uno strong. Anche se l’accuratezza raggiunta da questo modello e’ molto alta, il fatto che ci siano alcuni casi in cui abbiamo predetto che il cancro e’ benigno mentre invece e’ maligno non ci piace affatto, visto che si ha a che fare con le vite delle persone. Meglio caso mai avere un Falso negativo (diciamo che e’ maligno ma in realta’ e’ benigno) che oltre alla paura non fara’ altri danni alla persona sottoposta alla diagnosi. C’e’ da dire comunque che nel Machine learning e’ possibile provare a penalizzare gli esempi che ricadono nella casella FN rispetto a quella FP. In JMP Pro questo puo’ essere fatto direttamente dal Model Screening utilizzando l’opzione Decision Thresholds. Questa permette di esplorare la soglia dei modelli per la classificazione binaria. C’e’ un report per ogni modello specificato dal metodo di validazione.

Ogni report contiene un grafico della distribuzione delle probabilita’ previste, delle carte a barra per le diverse classificazioni e la matrice di confusione. Nelle barre la porzione in rosso e’ proporzionale all’errore di mis-classification. Spostando la linea nera al centro del grafico delle distribuzione si puo’ cambiare la soglia e cercare di diminuire il numero di falsi positivi rispetto a quelli negativi. Con la scelta operata nel nostro caso si e’ potuto ottenere un azzeramento dei Falsi positivi per le NN Boosted raggiungendo un’accuratezza del 100%.

Anche se in JMP le opzioni che vado a descrivere adesso vengono implementate automaticamente, in generale usando linguaggi come Python o R e le loro librerie, conviene prima di passare al training/test del modello di normalizzare le variabili X per esempio facendo in modo che tutti i predittori siano nel range 0-1 e che questi vengano trasformati con una funzione tipo logaritmo per cercare di eliminare la skewness della distribuzione. In definitiva i 5 steps piu’ importanti in ogni attivita’ di Machine learning sono:

1. Data collection: si tratta dello step dove viene raccolto il materiale da dare in pasto agli algoritmi per trasformarlo in conoscenza utilizzabile. Nella maggior parte dei casi i dati devono essere combinati in una singola sorgente come un file testo, csv o excel.

2. Data exploration/preparation: la qualita’ di qualsiasi progetto di machine learning dipende dalla qualita’ dei dati in ingresso. Quindi ogni qualvolta si parte col costruire un modello si devono pulire i dati dal rumore, eliminare quelli non necessari, e riempire le celle vuote del database (missing value).

3. Model training: una volta che i dati sono stati prepararti si divide il set in training/validation/test e si fa partire la ricerca

4. Model evaluation: poiche’ ogni machine learning tende ad essere biasato e’ importante valutare le prestazioni dell’algoritmo in termini di generalizzazione. Per fare questo si utilizzano diversi tipi di metriche a secondo che si tratta di un problema di regressione o di classificazione.

5. Model improvement: nel caso in cui siano necessarie prestazioni migliori si puo’ pensare di utilizzare delle strategie avanzate. Qualche volta basta cambiare il modello, o costruire dei nuovi predittori (feature engineering). Altre volte in caso di underfitting del sistema semplicemente raccogliere piu’ dati.